'Consultas' com Doutor Google e IA podem resultar em alucinações e colocar a saúde em risco

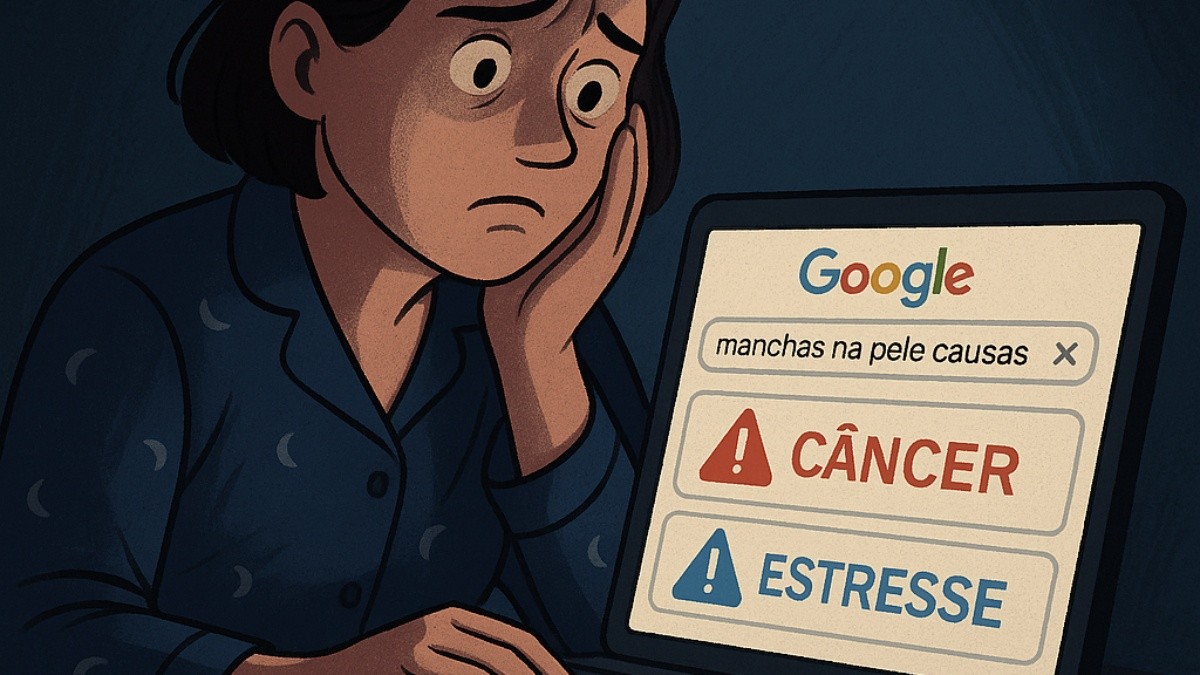

Especialistas detalham que ferramentas têm potencial desinformativo e que não substituem consulta com especialista. Ilustração gerada pelo ChatGPT sobre o tema da reportagem

ChatGPT

Buscar no "Doutor Google" ou perguntar a uma ferramenta de inteligência artificial o que pode estar por trás de um sintoma físico se tornou um hábito comum — mas nem sempre inofensivo. Médicos e pesquisadores alertam que essa prática, embora pareça prática, pode gerar diagnósticos errados, atrasar tratamentos importantes e até desencadear crises de ansiedade, especialmente em quem já é mais vulnerável emocionalmente.

Um estudo realizado pelo Instituto de Tecnologia de Illinois, nos Estados Unidos, mostra que ferramentas como o ChatGPT podem produzir respostas imprecisas ou sem base científica — o que os especialistas chamam de "alucinações". Este é apenas um dos riscos no uso descontextualizado da tecnologia no campo da saúde.

Abaixo, nesta reportagem, o g1 ouviu profissionais de saúde para entender os riscos desse comportamento e reunir orientações essenciais sobre como fazer buscas seguras na internet. Antes dos detalhes, veja um resumo com as dicas em 10 pontos:

Não faça autodiagnostico pela internet: Mesmo que pareça prático, buscar a causa de um sintoma no Google ou na IA pode levar a conclusões erradas e prejudiciais.

Não confie cegamente nas respostas da IA: Ferramentas como o ChatGPT constroem respostas com base em padrões de linguagem e podem apresentar alucinações — ou seja, inventar informações sem base científica.

O Google também pode induzir ao erro: Os resultados variam muito e vão desde causas inofensivas até doenças graves. Isso pode provocar tanto descuido quanto pânico desnecessário.

Diagnóstico envolve julgamento clínico — e isso a IA não tem: Ferramentas digitais não substituem o olhar médico, o exame físico e a escuta qualificada, que envolvem relação humana e interpretação contextual.

A internet pode ser gatilho para crises de ansiedade: Pessoas com transtornos de ansiedade podem ser especialmente afetadas ao buscarem explicações para um determinado sintoma, somatizando sintomas ou desenvolvendo novos por sugestão mental.

O risco de subestimar ou superestimar sintomas é real: Uma IA pode dizer que algo é simples quando é grave — ou vice-versa. Em ambos os casos, a saúde do paciente pode ser comprometida.

Use a internet com responsabilidade e senso crítico: A consulta a fontes confiáveis pode ajudar a compreender diagnósticos ou tratamentos após a avaliação médica, nunca como substituição.

Médicos também usam IA — mas com base científica: Profissionais podem empregar ferramentas para ler artigos ou apoiar decisões, mas sempre com respaldo técnico e experiência clínica.

Discuta o que encontrar online com seu médico: Caso encontre algo relevante em sua pesquisa, leve à consulta. O debate pode ser produtivo — desde que haja confiança no profissional.

Busque sempre fontes oficiais e confiáveis: Para minimizar o risco de desinformação, acesse apenas sites médicos reconhecidos, institutos de pesquisa e órgãos públicos de saúde.

Fantástico testa DeepSeek e explica susto causado pelo aplicativo chinês no mundo da Inteligência Artificial

Alucinação da IA x Caminhos do Google

Pesquisador CNPq do Laboratório de Estudos sobre Desordem Informacional e Políticas Públicas (DesinfoPop/CEAPG/FGV), Erlon Cugler explica que as "alucinações" da inteligência artificial podem ocorrer porque, ao construir uma frase, as IAs escolhem as melhores palavras para completar o raciocínio –e essa construção nem sempre é baseada em fatos ou ciência.

O nome dado a essa invenção é alucinação, comum entre esse tipo de IA. Por isso, usar essas ferramentas para buscar a causa de um possível problema de saúde pode ser perigoso.

Diretor do Pronto-Socorro do Hospital do Servidor Público Estadual, Werlley Januzzi diferencia as IAs generativas da busca no Google. Ambas oferecem resultados diferentes, mas tanto uma quanto a outra não são precisas.

Segundo ele, em vez de escolher as palavras com base no contexto, o Google navega por cenários e vincula àquela palavra tudo o que existe na plataforma relacionado a ela.

Por isso, a depender do sintoma pesquisado, o Google oferece desde respostas simples às mais complexas.

“Se um internauta pesquisa, por exemplo, manchas na pele, o Google pode dizer que se trata desde um resquício da exposição solar até um câncer grave. Para evitar esse tipo de diagnóstico equivocado, a melhor medida é se consultar com um médico”, diz.

Autodiagnosticar: caminho perigoso

Ainda segundo Januzzi, “se autodiagnosticar é um caminho perigoso”.

Diagnósticos via Google podem desencadear crise de ansiedade em quem já é ansioso

Freepik

Ele detalha que, para poder diagnosticar um problema de saúde, o médico tem de percorrer uma trajetória de pelo menos oito anos de estudo.

Não significa que esses especialistas não usem ferramentas de IA para ler artigos científicos e se informar, mas essa experiência clínica os faz conseguir categorizar aquele sintoma e relacioná-lo a outros sinais antes de bater o martelo sobre o diagnóstico.

“A Inteligência Artificial não tem capacidade de julgamento clínico, não palpa um pulso, não auscuta um pulmão. Diagnóstico envolve contato interpessoal e exame físico, a relação entre médicos e pacientes não deixa de ser uma relação afetiva. A IA não preenche requisitos mínimos para configurar impressão clínica. Vai te mostrar um cardápio de possibilidades referentes a aquele sintoma, fornecer algoritmos, mas existe uma lacuna enorme até qualquer chance de diagnóstico.”

Ao fornecer informações superficiais ou equivocadas, ferramentas de busca e de IA podem colocar a saúde em risco, alertam os especialistas. Ao fornecer o diagnóstico de uma condição simples, a IA pode desestimular esse usuário a buscar ajuda médica.

“Ao ser informado de que seu sintoma não é preocupante, o paciente pode negligenciar o problema, que pode, sim, ser grave”, diz Januzzi.

O oposto também gera alerta: às vezes, pode se tratar de uma condição simples, e as ferramentas analisarem como algo grave.

A resposta do Google ou da IA pode dizer algo do tipo "se esse sintoma estiver atrelado a algum outro específico, pode ser uma doença grave". Então, a pessoa, por medo, passa a sentir aquele sintoma. Nossa mente nos leva a lugares irracionais, e o corpo somatiza, não tem jeito”, diz o médico.

“Se o paciente já tem algum transtorno de ansiedade generalizada, pode ser um gatilho.”

ChatGPT responde a pergunta sobre manchas na pele

g1

Nunca é recomendado?

Os especialistas reiteram que, apesar de a internet não substituir uma consulta médica, ela pode ser aliada na hora de entender melhor alguns diagnósticos.

“Os médicos também fazem isso, porque existem IAs que simplificam artigos científicos, agilizam a leitura desse tipo de estudo. Não demonizo nem sou contra esse tipo de ferramenta, pelo contrário. Se usada com cuidado e responsabilidade, pode ser uma grande aliada dos tratamentos. A IA é uma ferramenta de pesquisa que ajuda a concatenar ideias, apenas isso”, diz.

“Se descobrir algo durante a pesquisa, leve esse resultado para o médico. Debata com ele, veja se faz sentido. O que não pode é achar que respostas da internet que forem de encontro às do médico estão erradas”, diz o cardiologista.

O pesquisador Cugler aconselha que, para consultar a internet com menos risco de desinformação, é imprescindível acessar apenas perfis oficiais.

ChatGPT

Buscar no "Doutor Google" ou perguntar a uma ferramenta de inteligência artificial o que pode estar por trás de um sintoma físico se tornou um hábito comum — mas nem sempre inofensivo. Médicos e pesquisadores alertam que essa prática, embora pareça prática, pode gerar diagnósticos errados, atrasar tratamentos importantes e até desencadear crises de ansiedade, especialmente em quem já é mais vulnerável emocionalmente.

Um estudo realizado pelo Instituto de Tecnologia de Illinois, nos Estados Unidos, mostra que ferramentas como o ChatGPT podem produzir respostas imprecisas ou sem base científica — o que os especialistas chamam de "alucinações". Este é apenas um dos riscos no uso descontextualizado da tecnologia no campo da saúde.

Abaixo, nesta reportagem, o g1 ouviu profissionais de saúde para entender os riscos desse comportamento e reunir orientações essenciais sobre como fazer buscas seguras na internet. Antes dos detalhes, veja um resumo com as dicas em 10 pontos:

Não faça autodiagnostico pela internet: Mesmo que pareça prático, buscar a causa de um sintoma no Google ou na IA pode levar a conclusões erradas e prejudiciais.

Não confie cegamente nas respostas da IA: Ferramentas como o ChatGPT constroem respostas com base em padrões de linguagem e podem apresentar alucinações — ou seja, inventar informações sem base científica.

O Google também pode induzir ao erro: Os resultados variam muito e vão desde causas inofensivas até doenças graves. Isso pode provocar tanto descuido quanto pânico desnecessário.

Diagnóstico envolve julgamento clínico — e isso a IA não tem: Ferramentas digitais não substituem o olhar médico, o exame físico e a escuta qualificada, que envolvem relação humana e interpretação contextual.

A internet pode ser gatilho para crises de ansiedade: Pessoas com transtornos de ansiedade podem ser especialmente afetadas ao buscarem explicações para um determinado sintoma, somatizando sintomas ou desenvolvendo novos por sugestão mental.

O risco de subestimar ou superestimar sintomas é real: Uma IA pode dizer que algo é simples quando é grave — ou vice-versa. Em ambos os casos, a saúde do paciente pode ser comprometida.

Use a internet com responsabilidade e senso crítico: A consulta a fontes confiáveis pode ajudar a compreender diagnósticos ou tratamentos após a avaliação médica, nunca como substituição.

Médicos também usam IA — mas com base científica: Profissionais podem empregar ferramentas para ler artigos ou apoiar decisões, mas sempre com respaldo técnico e experiência clínica.

Discuta o que encontrar online com seu médico: Caso encontre algo relevante em sua pesquisa, leve à consulta. O debate pode ser produtivo — desde que haja confiança no profissional.

Busque sempre fontes oficiais e confiáveis: Para minimizar o risco de desinformação, acesse apenas sites médicos reconhecidos, institutos de pesquisa e órgãos públicos de saúde.

Fantástico testa DeepSeek e explica susto causado pelo aplicativo chinês no mundo da Inteligência Artificial

Alucinação da IA x Caminhos do Google

Pesquisador CNPq do Laboratório de Estudos sobre Desordem Informacional e Políticas Públicas (DesinfoPop/CEAPG/FGV), Erlon Cugler explica que as "alucinações" da inteligência artificial podem ocorrer porque, ao construir uma frase, as IAs escolhem as melhores palavras para completar o raciocínio –e essa construção nem sempre é baseada em fatos ou ciência.

O nome dado a essa invenção é alucinação, comum entre esse tipo de IA. Por isso, usar essas ferramentas para buscar a causa de um possível problema de saúde pode ser perigoso.

Diretor do Pronto-Socorro do Hospital do Servidor Público Estadual, Werlley Januzzi diferencia as IAs generativas da busca no Google. Ambas oferecem resultados diferentes, mas tanto uma quanto a outra não são precisas.

Segundo ele, em vez de escolher as palavras com base no contexto, o Google navega por cenários e vincula àquela palavra tudo o que existe na plataforma relacionado a ela.

Por isso, a depender do sintoma pesquisado, o Google oferece desde respostas simples às mais complexas.

“Se um internauta pesquisa, por exemplo, manchas na pele, o Google pode dizer que se trata desde um resquício da exposição solar até um câncer grave. Para evitar esse tipo de diagnóstico equivocado, a melhor medida é se consultar com um médico”, diz.

Autodiagnosticar: caminho perigoso

Ainda segundo Januzzi, “se autodiagnosticar é um caminho perigoso”.

Diagnósticos via Google podem desencadear crise de ansiedade em quem já é ansioso

Freepik

Ele detalha que, para poder diagnosticar um problema de saúde, o médico tem de percorrer uma trajetória de pelo menos oito anos de estudo.

Não significa que esses especialistas não usem ferramentas de IA para ler artigos científicos e se informar, mas essa experiência clínica os faz conseguir categorizar aquele sintoma e relacioná-lo a outros sinais antes de bater o martelo sobre o diagnóstico.

“A Inteligência Artificial não tem capacidade de julgamento clínico, não palpa um pulso, não auscuta um pulmão. Diagnóstico envolve contato interpessoal e exame físico, a relação entre médicos e pacientes não deixa de ser uma relação afetiva. A IA não preenche requisitos mínimos para configurar impressão clínica. Vai te mostrar um cardápio de possibilidades referentes a aquele sintoma, fornecer algoritmos, mas existe uma lacuna enorme até qualquer chance de diagnóstico.”

Ao fornecer informações superficiais ou equivocadas, ferramentas de busca e de IA podem colocar a saúde em risco, alertam os especialistas. Ao fornecer o diagnóstico de uma condição simples, a IA pode desestimular esse usuário a buscar ajuda médica.

“Ao ser informado de que seu sintoma não é preocupante, o paciente pode negligenciar o problema, que pode, sim, ser grave”, diz Januzzi.

O oposto também gera alerta: às vezes, pode se tratar de uma condição simples, e as ferramentas analisarem como algo grave.

A resposta do Google ou da IA pode dizer algo do tipo "se esse sintoma estiver atrelado a algum outro específico, pode ser uma doença grave". Então, a pessoa, por medo, passa a sentir aquele sintoma. Nossa mente nos leva a lugares irracionais, e o corpo somatiza, não tem jeito”, diz o médico.

“Se o paciente já tem algum transtorno de ansiedade generalizada, pode ser um gatilho.”

ChatGPT responde a pergunta sobre manchas na pele

g1

Nunca é recomendado?

Os especialistas reiteram que, apesar de a internet não substituir uma consulta médica, ela pode ser aliada na hora de entender melhor alguns diagnósticos.

“Os médicos também fazem isso, porque existem IAs que simplificam artigos científicos, agilizam a leitura desse tipo de estudo. Não demonizo nem sou contra esse tipo de ferramenta, pelo contrário. Se usada com cuidado e responsabilidade, pode ser uma grande aliada dos tratamentos. A IA é uma ferramenta de pesquisa que ajuda a concatenar ideias, apenas isso”, diz.

“Se descobrir algo durante a pesquisa, leve esse resultado para o médico. Debata com ele, veja se faz sentido. O que não pode é achar que respostas da internet que forem de encontro às do médico estão erradas”, diz o cardiologista.

O pesquisador Cugler aconselha que, para consultar a internet com menos risco de desinformação, é imprescindível acessar apenas perfis oficiais.

Para ler a notícia completa, acesse o link original:

0 curtidas

Notícias Relacionadas

Não há mais notícias para carregar

Comentários 0